- 绿色版查看

- 绿色版查看

- 绿色版查看

- 绿色版查看

- 绿色版查看

主要功能

Ollama支持从官方模型库或自定义模型库拉取预训练模型,并在本地保存和加载,同时兼容ONNX、PyTorch、TensorFlow等多种流行的模型格式。通过GPU/CPU加速,Ollama提供高效的模型推理,适合本地化应用或需要控制数据隐私的场景。它支持多种接口访问推理服务,包括命令行(CLI)、HTTP接口,并可通过OpenAI客户端实现更广泛的集成。此外,用户还可以通过灵活的环境变量自定义推理设备(GPU/CPU)、缓存路径、并发数、日志级别等。

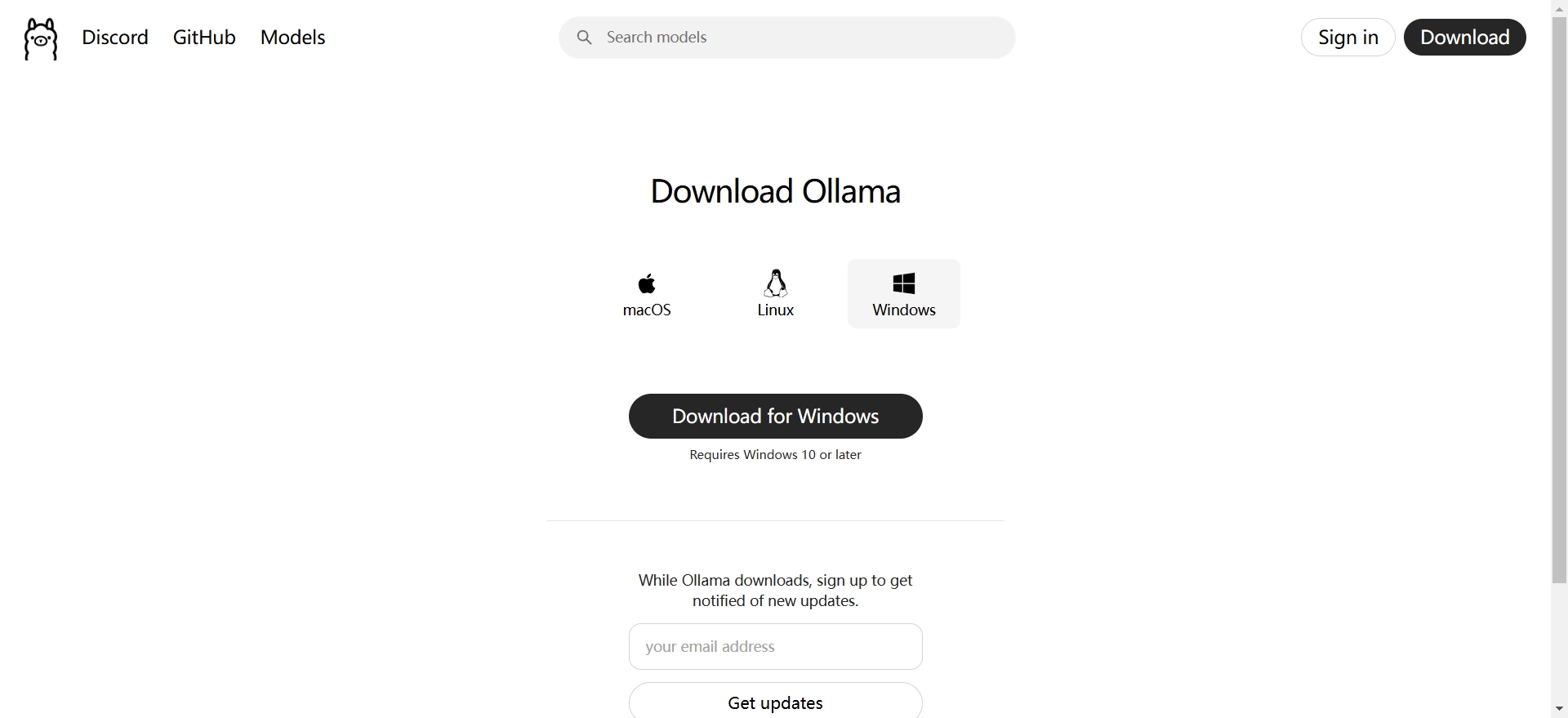

安装与配置

用户可以从Ollama官网下载桌面软件,或通过命令行安装Ollama CLI工具。安装完成后,用户可以通过环境变量进行配置,如指定模型存储路径、选择推理使用的设备、设置日志级别等。Ollama还提供了多种命令,方便用户进行模型管理和推理,如查看帮助信息、查看可用模型、拉取模型、删除模型、检查模型状态等。

应用场景

Ollama适用于多种场景,包括但不限于:

1.数据隐私保护:对于担心数据发送到云端会产生安全风险的用户,Ollama可以在本地处理数据,避免数据传输到外部服务器带来的潜在风险。

2.开发和测试:开发人员可以使用Ollama在本地快速搭建语言模型环境,用于开发新的语言相关的应用程序,如智能客服机器人等。

3.个人学习和研究:对于研究自然语言处理的学者或对语言模型感兴趣的个人来说,Ollama提供了一个方便的实验平台,可以在本地加载不同的模型,对比它们的性能,研究模型的输出特性等。

优势特点

1.轻量化设计:Ollama工具体积小巧,安装简便,不会占用过多系统资源。

2.多模型支持:除了支持DeepSeek外,Ollama还支持Llama、Qwen等其他流行的大型语言模型。

3.社区支持:Ollama拥有活跃的开发者社区,提供了丰富的文档和教程,帮助用户解决遇到的各种问题。

ollama更新日志:

1. 优化的脚步从未停止!

2. 更多小惊喜等你来发现~

华军小编推荐:

ollama功能和官方出品的一样齐全,界面更加美观大方,设计更完善,不断满足用户的需求欢迎下载。感兴趣的还可以下载今目标、汉王考勤管理系统、爱莫脑图、NTKO 大文件上传控件、快刀客平台软件

您的评论需要经过审核才能显示